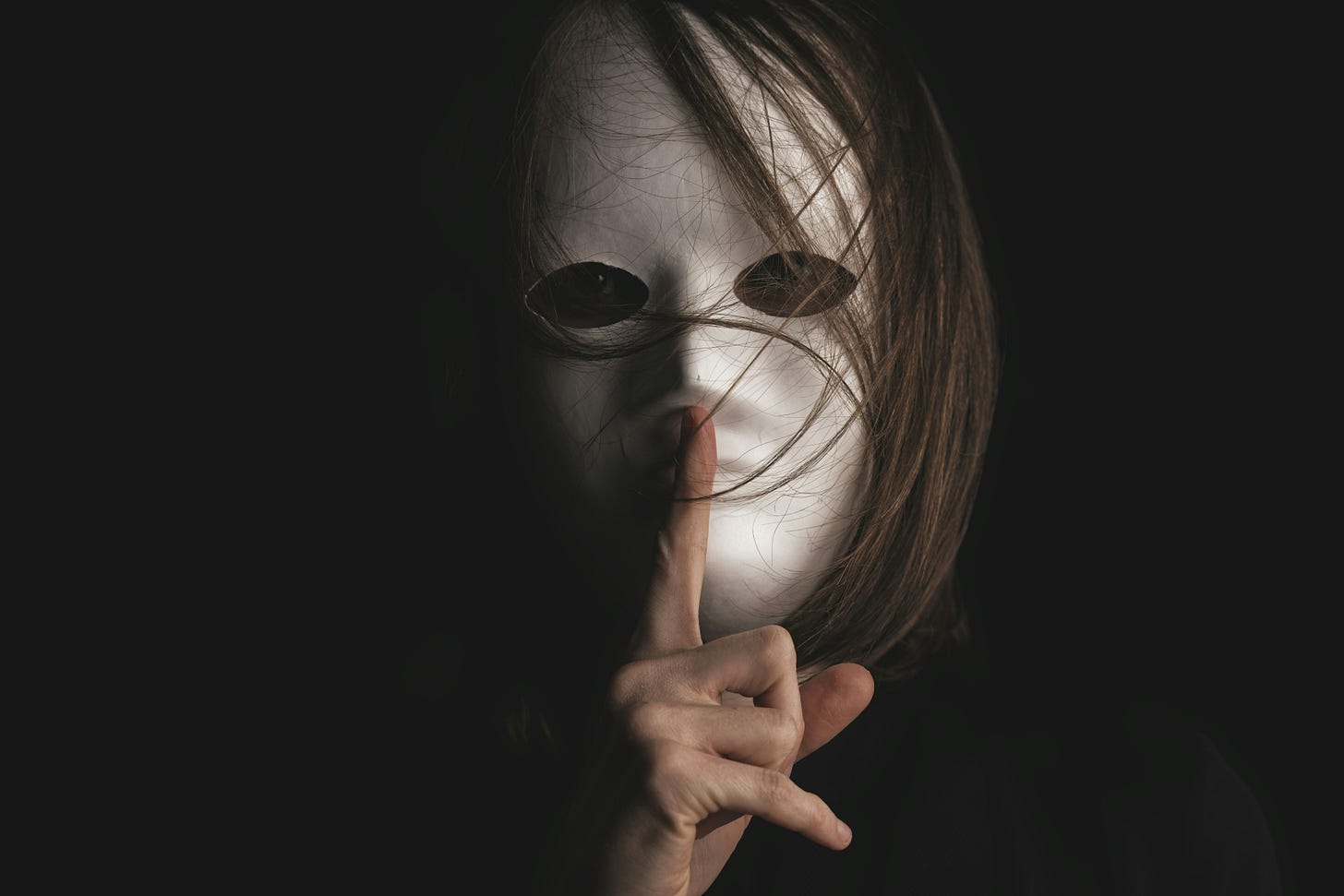

#66 - existe "verdade demais"?

censura, sir Elton John, viés algorítmico...

verdade demais? a condenação de uma jornalista e o preço da informação

a primeira das notícias escolhidas de hoje não tem nada de tech, apesar disso estar acontecendo de monte no universo da proteção de dados. fica esse alerta.

nunca é demais lembrar que a defesa de regimes democráticos ocorre por várias vias: voto popular, controle de atos pelo judiciário, imprensa livre para informar, etc.

além disso, quem está no setor público tem ainda de lidar com as regras de transparência.

e daí surge o ABSURDO que você está prestes a ler.

uma jornalista foi condenada a pagar R$ 600 mil de indenização por danos morais a uma magistrada.

mas ela mentiu? não. ela inventou? não.

ela apenas publicou o salário de uma desembargadora em uma reportagem sobre supersalários no Judiciário.

pior, a sentença reconhece que a informação era verdadeira, mas afirma que a jornalista “extrapolou o direito de informar”.

extrapolou o direito de informar?

o que está acontecendo?

em uma dessas tantas matérias investigativas que escancaram os supersalários do topo do serviço público, uma jornalista incluiu o nome da desembargadora e seu respectivo rendimento.

mas como ela conseguiu essa informação?

tudo público. tudo transparente. tudo disponível, aliás, no Portal da Transparência.

a magistrada subiu no salto, disse que teve sua intimidade invadida, e decidiu processar jornal e jornalista.

o pior: ganhou R$ 600 mil.

por que isso importa? 💡

porque estamos diante de uma decisão que não censura a mentira, mas pune a verdade, uma verdade que a magistrada achou desconfortável.

a sentença reconhece que os dados eram verídicos.

que a repórter estava no exercício da profissão.

e, ainda assim, considerou que a exposição do salário público de uma servidora pública, obtido por meio de recurso público, viola direitos individuais.

“verdade demais”?

e agora?

esse caso não é apenas sobre uma repórter, ou um caso isolado.

é sobre o espaço da crítica em uma democracia.

é sobre a função social do jornalismo.

e, sobretudo, é sobre os riscos da criação de uma jurisprudência de silenciamento.

se a verdade desconfortável agora fere, quem poderá ainda fiscalizar o poder? se os dados públicos se tornam blindados por sensibilidades privadas, o que sobra do interesse coletivo?

no fundo, e nem precisa ir lá tão fundo, todo mundo sabe o nome disso: CENSURA!

Sir Elton John está pistola com o modelo “se não quer, grite”

uma das grandes questões jurídicas do nosso tempo — a propriedade intelectual na era da inteligência artificial — parece prestes a ganhar um novo capítulo, e ele atende pelo nome de Data Bill, e tem figurões reais (nada de virgínias da vida) pregando contra.

o governo britânico está considerando permitir que empresas de IA usem obras protegidas por direito autoral — músicas, livros, ilustrações, tudo — sem pedir permissão prévia.

a única exigência? que os autores digam ativamente que não querem.

ou seja: um modelo de opt-out.

obviamente, Sir Elton John não ficou calado:

“É um crime. O governo está traindo toda uma geração criativa.”

e ele está certo, a proposta é absurda.

o que está acontecendo?

o projeto em discussão nas terras de Charlinho permitiria que empresas de IA treinassem seus modelos em conteúdo protegido por copyright, sem precisar de licença prévia, desde que os autores não tenham se manifestado contra.

isso criaria a seguinte “lógica”: quer proteger sua obra? descubra onde ela está sendo usada, corra atrás de um formulário e torça para que respeitem.

o modelo opt-out, travestido de equilíbrio, inverte a lógica da proteção autoral.

e transforma o silêncio em consentimento.

por que isso importa? 💡

porque o modelo opt-out favorece quem tem poder de processamento, não quem tem criatividade.

💡 grandes empresas de tecnologia operam em escala, e certamente raspariam todo material mais rápido do que qualquer artista teria de se opor.

💡 autores independentes, músicos, jornalistas e ilustradores… não.

a obrigação de dizer “não” deveria ser de quem quer explorar, não de quem criou.

Além disso, o opt-out exige que o criador tenha conhecimento, meios e acesso para se opor, e muitos não têm.

por que a grita de Sir Elton John é importante?

ao chamar os ministros de “absolute losers”, o artista (real, repito) coloca o dedo na ferida de um sistema que parece feito para legalizar a apropriação indevida discreta, em massa e sob demanda. é o velho truque do “tecnológico demais para ser injusto”.

e agora?

o modelo opt-out é uma forma disfarçada de dar carta branca às big techs, mascarando extração como inovação.

e, o mais importante pra nós, se essa lógica vingar nas terras de Charlinho, pode virar tendência, e outros países virão atrás.

um algoritmo (enviesado) que decide se você é ou não um bom pai

tem notícia que parece saída direto de black mirror para essa newsletter, e essa é uma delas.

em Nova York, um algoritmo criado pela própria agência de proteção à infância (ACS) está ajudando a decidir quais famílias devem ser vigiadas, visitadas e, potencialmente, separadas.

como eu disse, não se trata de episódio de black mirror, mas sim da vida real de muitas pessoas, algumas das quais monitoradas desde a gravidez, sem que tenham cometido qualquer crime.

o motivo? basta ter crescido no sistema de adoção, ou ter tido depressão pós-parto no passado ou morar em um bairro pobre.

e o mais surreal é que muitas mulheres perdem seus filhos por causa de uma variável invisível em uma planilha que elas nunca viram.

o que está acontecendo?

o ACS utiliza um algoritmo com 279 variáveis para prever quais crianças correm maior risco de serem severamente feridas em casa.

essa pontuação pode levar a visitas, consultas com especialistas, ligações para escolas e familiares, mas nada disso é informado às famílias ou seus advogados. nem mesmo os próprios assistentes sociais sabem quando o algoritmo entrou em ação.

ou seja, como num roteiro distópico, você não sabe que está sendo julgado, mas está.

e o que entra nesse cálculo?

bairro onde você mora

idade da mãe

número de filhos

saúde física e mental

histórico de chamadas à ACS (mesmo infundadas)

por que isso importa? 💡

porque basta olhar as variáveis acima para saber que a matemática da suspeita tem cor, classe e CEP.

mesmo sem usar “raça” como variável direta, o algoritmo usa proxies perfeitos para chegar ao mesmo lugar: bairros de baixa renda, famílias negras e latinas, mães solo, pessoas com histórico de saúde mental.

estamos diante de uma nova geração de tecnologia invisível, implacável e opaca, que toma decisões que mudam vidas — sem responsabilidade, sem transparência e sem contraditório.

o caso da ACS é um exemplo emblemático de discriminação algorítmica, termo que descreve quando sistemas automáticos reproduzem e amplificam preconceitos.

em uma sociedade marcada por desigualdades, o que parece técnico muitas vezes é apenas uma nova roupagem para o velho viés, ou preconceito, se preferir.

antes de partir: muita gente anda me pedindo para criar uma lista de melhores apps de IA para cada utilização. longe de querer ser o dono dessa informação, a verdade é que uso várias ferramentas, a depender da finalidade.então é isso. obrigado por ler. estaremos de volta daqui a duas semanas, a não ser que seja acionado o plantão do Ruy…

Fiquei aterrorizada com a parte sobre ACS. Imagina se isso se alastra pelo mundo, ainda nem conseguimos enfiar na cabeça de tantas pessoas sobre o racismo estrutural, sobre preconceitos… imagina agora com uma arma ainda mais poderosa, letal e revestida de uma pseudo veracidade.