#63 - você também foi pego?

mangá bonitinho ou a maior coleta de dados dos últimos anos? seu DNA vale menos que uma mc oferta. não acredite em imagens, afinal nada mais é o que parece...

que fofo esse Ghibli… ahã, claro, claro…😈

é muito provável que você, enquanto habitante do planeta azul, tenha tido seu feed de redes sociais inundado por imagens bonitinhas ao longo da semana passada.

também é provável que você ou algum conhecido próximo tenha entrado nessa trend, feito algumas imagens para postar nas redes.

pois vou te contar direitinho o que está acontecendo, mas te garanto que está longe de ser só uma brincadeira fofinha.

o que está acontecendo?

as imagens são uma reprodução do estilo Ghibli (esse é outro assunto gigante, que nem cabe nas news de hoje), e foram geradas pelo novo modelo de imagens do ChatGPT.

bastou um único post de Sam Altman, o big boss da OpenAI, no X (antigo passarinho), para que tivesse início uma verdadeira avalanche. a imagem é essa abaixo:

milhões de pessoas (literalmente) começaram a enviar fotos suas, de familiares, amigos, bichinhos de estimação, em busca de uma versão fofinha em anime. teve gente que enviou até foto íntima.

ok, mas qual o verdadeiro problema por detrás disso? com esse viral, a OpenAI está coletando imagens fresquinhas de milhões de rostos ao redor do globo, sem precisar fazer nenhum esforço, nem mesmo gastar $$$ raspando as redes sociais.

por que isso importa? 💡

porque foi uma manobra pensada (de forma genial, convenhamos) para contornar algumas das maiores barreiras legais de proteção de dados, especialmente na Europa e países como Lulaland, onde as leis tem inspiração europeia.

vou explicar…

enquanto o uso de imagens “raspadas” da internet exige o cumprimento de uma série de requisitos e cuidados legais (não vou explicar aqui para não ficar chatona essa news), as imagens que você mesmo envia voluntariamente entram por outra porta: o consentimento.

e daí? daí que a política de privacidade da OpenAI (que quase ninguém leu) é clara ao dizer que os dados inseridos por usuários podem ser usados para treinar os modelos, caso você não opte por sair. mas como você não leu, você sequer sabe disso.

sob esse prisma, a OpenAI não violou nenhuma regra. pelo contrário: usou o super manjado truque de gerar uma experiência viral, fofa e divertida — e que lhe rendeu milhões de dados novinhos.

duro admitir, mas o case representa um baita de um exemplo de engenharia social em escala global.

para se aprofundar 🤿

e a questão é bem ampla, pode acreditar. só para você ter uma ideia do que esse case de engenharia social representa:

“caminhão” de dados visíveis: não apenas selfies ou imagens já postadas anteriormente…muita gente está mandando imagens familiares, íntimas e exclusivas, que jamais estariam disponíveis publicamente. isso enriquece os datasets da OpenAI com material único e atual.

“caminhão” de dados invisíveis: uma imagem revela muito mais do que apenas sua superfície visível. para além de poses e sorrisos, imagens têm também uma série de metadados. os metadados de uma imagem de iPhone podem incluir, dentre outros:

data e hora da captura

localização geográfica

modelo e fabricante da câmera

manobra jurídica: ao usar o consentimento como base legal, a OpenAI evita as limitações impostas pela legislação, o que significa menos proteção aos usuários e mais margem de manobra para a empresa.

só a OpenAI tem o original: os concorrentes só verão a versão transformada, com olhos grandes e cenários encantados, ainda assim se você postar. o conjunto de dados original? é exclusivo.

hábito moldado pela FOMO: cada dia mais, as pessoas são pegas pela FOMO (síndrome de ficar de fora - fear of missing out). a cada trend, mais rostos, mais vozes, mais dados.

fica o recado: da próxima vez que uma trend IA parecer irresistível, pare, respire, e se seu s..o não estiver muito cheio, leia a política de privacidade antes de entrar na onda.

a era da confiança visual acabou!

tá bom, sei que já falei disso aqui antes, mas a coisa está ganhando uma dimensão ainda maior, e em velocidade incrível.

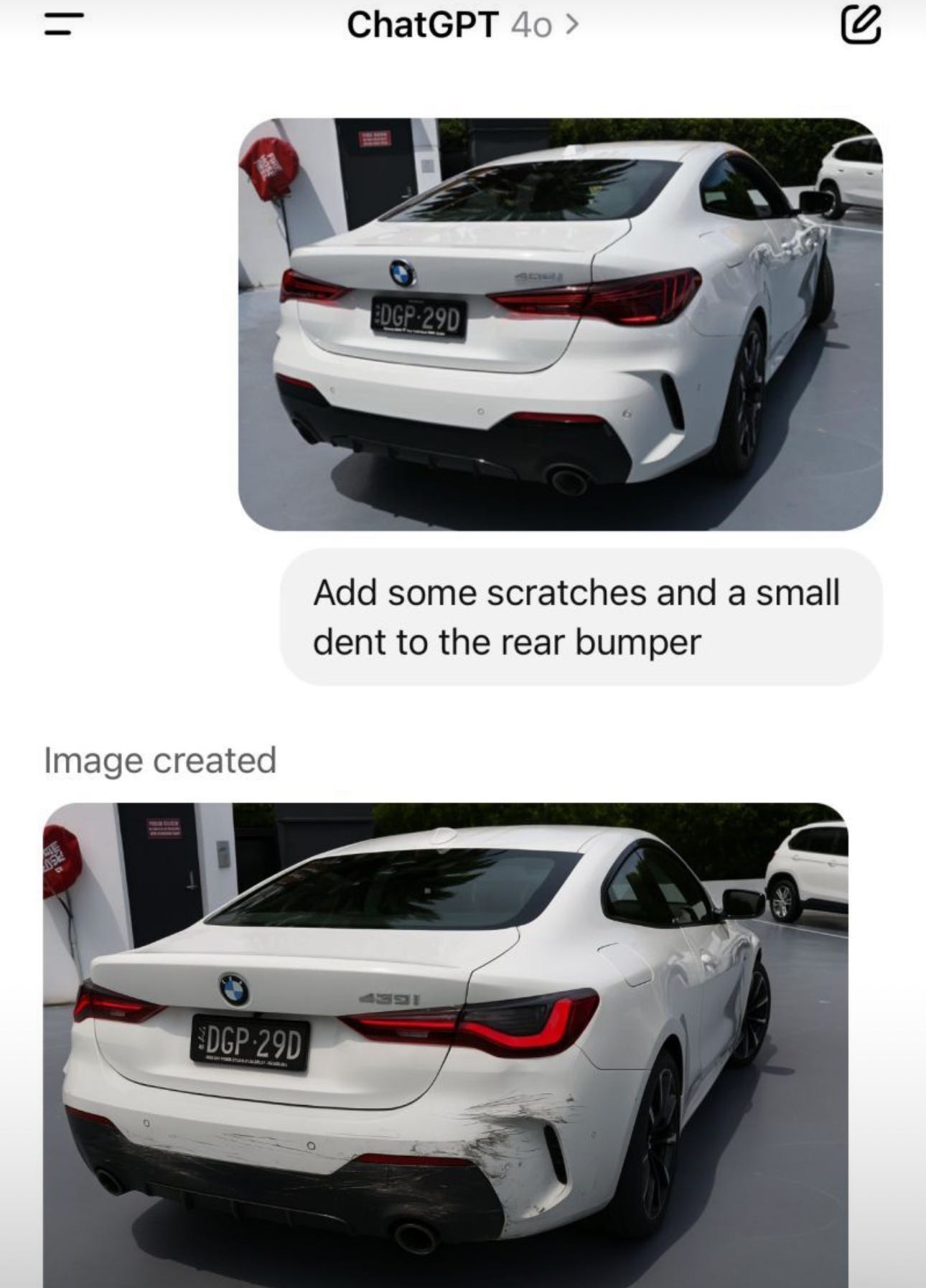

o tal novo modelo de geração de imagens da OpenAI, o mesmo que gerou as imagens em estilo Ghibli (notícia acima), agora é capaz de produzir imagens com inserção de textos em níveis absurdamente realísticos, com direito a letras legíveis, continuidade entre imagens e aparência realista o suficiente para enganar qualquer pessoa.

por que isso importa? 💡

de reembolsos a aluguéis, passando por devoluções no e-commerce e comprovantes de pagamento, chegando até a fraudes mais sofisticadas com verificação de identidade, tirar uma foto de um documento ou recibo tinha virado quase que um pré-requisito para muita coisa.

pois bem, mas e agora, já que qualquer pessoa com um mínimo de conhecimento pode criar essa "prova" do zero, em minutos e de graça?

só um pequeno apanhado de possibilidades:

reembolsos – gastei 298 Lulas no almoço com o cliente? não. mas tenho um recibo de restaurante falso com a logo perfeita e tudo.

devoluções online – produto quebrado? envio uma imagem com o item danificado e o comprovante de compra... ambos gerados por IA.

aluguel ou crédito – precisa de comprovante de renda ou conta de luz? Sem problema, o gerador faz.

verificação de identidade – uma selfie com um documento? vários editores de imagens já eram capazes de fazer, mas agora qualquer um com um celular e um prompt decente pode burlar o sistema.

isso significa que sistemas de confiança baseados em “manda uma foto pra provar” estão com os dias contados.

dá uma olhada nos exemplos:

para se aprofundar 🤿

a facilidade em criar falsificações visuais com IA está nos levando a uma situação bastante difícil, em especial porque a grande maioria da população não tem o mínimo de informação necessária para se proteger em relação a esses riscos que estão sendo diariamente ampliados.

pense que estamos diante de uma potencial escalada silenciosa dos golpes: antes, falsificações exigiam software, paciência e algum talento. agora, exigem... um prompt bem escrito. a barreira de entrada para fraudes caiu drasticamente, e o impacto será sentido não só por empresas, mas por instituições financeiras, imobiliárias, varejo e até o setor público.

não é exagero: estamos diante de um cenário em que a confiança visual virou uma ilusão.

a IA não vai apenas gerar imagens – ela já começou a demolir a ideia de prova visual como a conhecemos.

seu DNA sendo vendido por 25 Lulas?

é o que poderia acontecer se você tivesse feito algum teste genético com umas das gigantes do mercado, a pioneira 23andMe. seu DNA valeria menos que uma mc oferta.

vem entender o que está acontecendo…

a 23andMe, pioneira dos testes de DNA domésticos, entrou com pedido de falência em Trumplandia. e, como consequência disso, está prestes a vender os dados genéticos de 15 milhões de pessoas que a contrataram para conhecer suas raízes, potenciais doenças, etc.

e agora, tudo isso pode acabar nas mãos de qualquer um, QUALQUER UM, isso porque um juiz lá nos States autorizou a empresa a buscar propostas para a venda desses dados. se não houver intervenção, alguém que reverta essa decisão, é provável que esses dados acabem nas mãos de alguém que queira encontrar uma forma lucrativa de usá-los.

por que isso importa? 💡

porque dados genéticos são dados sensíveis. porque dados genéticos não expiram.

você pode mudar de CPF, de endereço, até de senha. mas se alguém tiver acesso ao seu DNA, esse alguém terá uma chave biológica que vale para hoje, amanhã e para o resto da sua vida.

agora imagine essa chave sendo usada:

para prever seu risco de doenças e vender isso a seguradoras.

para te identificar em bancos genéticos, com apoio de governos.

por cibercriminosos, criando perfis hiperpersonalizados para ataques futuros.

e o pior: tudo isso pode acontecer sem que você saiba, sem que você permita — e sem volta.

para se aprofundar 🤿

o caso parece roteiro de série distópica da Netflix, mas não é.

com menos de 4% dos usuários pagando por assinatura, a 23andMe fracassou no seu modelo de negócio e agora, na falência, os dados viraram o ativo mais valioso da empresa.

mas há expectativa positiva para os usuários desses testes? sim.

nos anos 2000, o FTC (órgão regulador dos EUA) impediu a venda de dados dos clientes da ToySmart, alegando que os consumidores não tinham consentido com novos usos. em 2015, o mesmo aconteceu com a falência da RadioShack, que foi obrigada a destruir os dados.

a solução seria exigir que cada usuário opte ativamente por permitir a transferência dos seus dados genéticos. sem opção ativa? sem venda, sendo que os dados devem ser apagados se não houver consentimento.

pense bem quando for fazer qualquer negócio onde os ativos sejam seus dados sensíveis, desde testes genéticos com empresas privadas, até a venda de sua íris. nunca se sabe o que acontecerá no futuro.

então é isso. obrigado por ler. estaremos de volta daqui a duas semanas, a não ser que seja acionado o plantão do Ruy…

Sensacional !

Muito massa as news de hoje!